激光雷达与视觉方案确实不是矛盾关系,而是高度互补的协同技术,尤其在恶劣环境(夜晚、高速)下能显著弥补纯视觉的短板。

同样的路,有测评团队开着小米SU7(图片|配置|询价)激光版晚上又走一遍,正常识别维修路障,正常降速拐入车道 。 视觉版开到100就提示接管,依然是两秒多反应时间,但是老司机注意力集中正常接管。真是可惜如果买车时多加2万块,那3条姑娘就会没事了。

1. 原理互补性

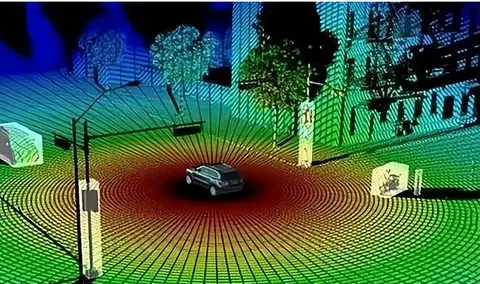

激光雷达:主动发射激光,直接获取高精度三维点云数据,测距误差可控制在厘米级。在夜晚、雨雾等低光环境下仍能稳定工作(如10%反射率目标探测距离可达200米以上)。

视觉方案:依赖环境光成像,夜间或极端天气下信噪比骤降,100米远距离测距误差可能超过10%。例如,特斯拉纯视觉系统在暴雨中对静止障碍物的漏检率显著高于激光雷达方案。

2. 恶劣环境表现对比

夜晚场景:激光雷达不受光照影响,1550nm波长产品(如镭神智能)夜间探测距离可达500米;视觉摄像头需依赖高感光元件和算法补偿,但远距离细节仍易丢失。

雨雾天气:激光雷达通过纳米疏水涂层(如南京信息工程大学方案)和多次回波技术,在降雨中保持92.79%的探测率;视觉摄像头则因雨滴折射和镜头污渍导致成像模糊。

激光雷达与视觉的互补性已成为行业共识,尤其在安全关键场景中,融合方案是不可逆的趋势。

很多人说当激光雷达与视觉方案的数据出现矛盾时,谁准确? 发生事故后来判断谁对谁错?

这是另外一个问题,数据矛盾的处理。不要对个案来判断,因为矛盾处理没有固定规则,而是通过算法动态权衡,最终“矛盾”将逐步减少到一个极低远低于人类犯错的一个级别。

比如2024年交通死亡率0.0001人/车,死亡6万多人,大规模普及智能驾能把死亡率降低到0.00001人/车,死亡6千人就是巨大的进步。随着进步降低到L4级别600,L5级别6个。到时候不要辩论L5级别依然死了6个人证明智驾没有用,应该选死6万人的人驾驶方案,那是脑袋有问题。

1. 矛盾处理的核心原则

安全优先:系统会优先选择能提供更高可靠性数据的传感器。例如,激光雷达在夜间或雨雾天气的测距数据通常比视觉更可信。

场景适配:算法会根据实时环境动态调整权重。例如:

强光/逆光:视觉数据可能失效,系统依赖激光雷达。

雨雾天气:激光雷达可能因雨滴干扰出现噪点,此时视觉+毫米波雷达的数据会被加权。

冗余校验:若双方数据差异过大,系统可能触发降级策略(如提示人工接管)。

2. 技术实现路径

后融合(主流方案):各传感器独立生成目标后,在决策层融合。优势是容错性高,但可能损失信息一致性。

前融合(未来趋势):原始数据直接融合(如BEVFusion框架),通过Transformer等模型实现时空对齐,提升决策精度。华为ADS 3.0和小鹏XNGP均采用此类技术。

3. 行业实践案例

华为方案:激光雷达作为主传感器,视觉辅助语义识别。矛盾时以激光雷达的物理测距数据为准。

小鹏融合方案:动态加权算法会根据置信度自动选择数据源,例如对静止障碍物优先采用激光雷达。

矛盾处理没有固定规则,而是通过算法动态权衡。未来随着端到端融合技术的发展,传感器间的“矛盾”将逐步减少。

渝公网安备50010502503425号

渝公网安备50010502503425号

评论·0